Với tư cách là một người dùng công nghệ, tôi chưa bao giờ thực sự thoải mái khi sử dụng các mô hình ngôn ngữ lớn (LLM) dựa trên đám mây. Hầu hết chúng yêu cầu gửi dữ liệu cá nhân của bạn đến các máy chủ từ xa, điều này làm nảy sinh những lo ngại rõ ràng về quyền riêng tư. Hơn nữa, nhiều công cụ AI bị khóa sau các gói đăng ký đắt đỏ, và bạn có rất ít quyền kiểm soát cách chúng hoạt động.

Với tốc độ cải thiện nhanh chóng của các mô hình AI cục bộ, tôi muốn thử xem liệu việc tự chạy LLM trên thiết bị cá nhân đã thực sự khả thi hay chưa. Có nhiều lý do hấp dẫn để thử tự host các mô hình ngôn ngữ lớn này, vì vậy tôi đã quyết định thử và thực sự cảm thấy vô cùng kinh ngạc với kết quả đạt được.

Ollama Giúp Thiết Lập LLM Cục Bộ Dễ Dàng Đến Bất Ngờ

Đơn Giản Ngay Cả Với Người Mới Tự Host

Đối với thiết lập của tôi, tôi đã chọn Ollama làm công cụ cốt lõi để vận hành các mô hình ngôn ngữ. Nếu bạn chưa từng nghe đến, Ollama là một framework gọn nhẹ được thiết kế để giúp việc chạy các mô hình ngôn ngữ lớn (LLM) tại chỗ trở nên dễ tiếp cận hơn nhiều. Nó xử lý toàn bộ quá trình, từ việc tải xuống các file mô hình đến thiết lập môi trường chạy và quản lý tài nguyên phần cứng.

Bạn có thể chạy các mô hình chỉ với một vài lệnh terminal đơn giản mà không cần tự mình xử lý tất cả các cấu hình backend phức tạp thường đi kèm với các LLM cục bộ. Ollama hoạt động hoàn toàn trên máy tính của bạn, đảm bảo rằng các mô hình và dữ liệu luôn ở trạng thái cục bộ. Nó hỗ trợ hầu hết các mô hình mã nguồn mở phổ biến như DeepSeek, LLaMA, và bạn thậm chí có thể tải mô hình riêng của mình nếu muốn. Ollama cũng tự động xử lý các tối ưu hóa để đảm bảo các mô hình chạy hiệu quả dựa trên cấu hình phần cứng của bạn.

Mặc dù Ollama không được đóng gói dưới dạng container theo mặc định, tôi đã chạy toàn bộ hệ thống bên trong Docker để giữ mọi thứ cô lập và dễ quản lý hơn. Điều này cũng giúp thiết lập trở nên di động và tránh mọi xung đột với các phụ thuộc khác trên hệ thống của tôi.

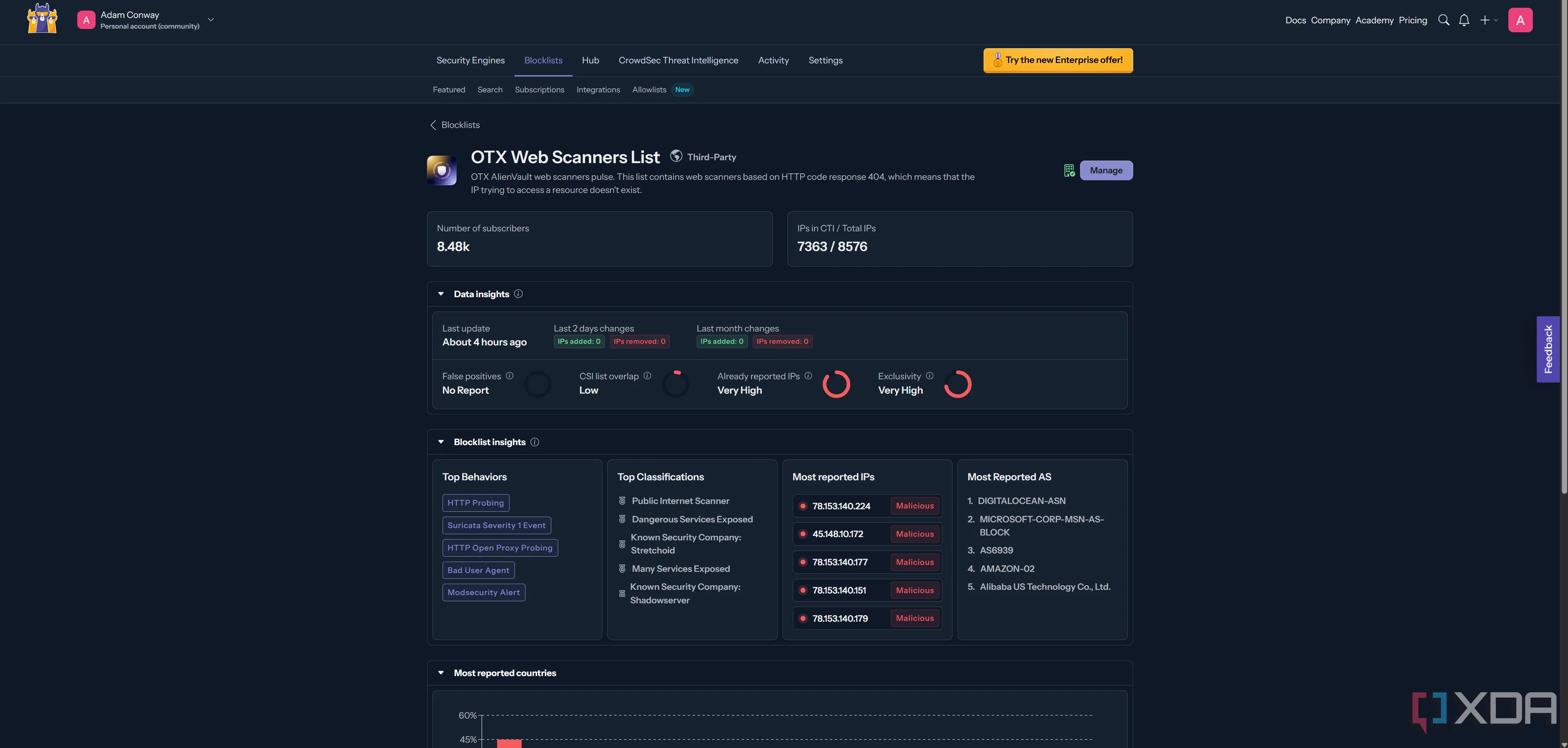

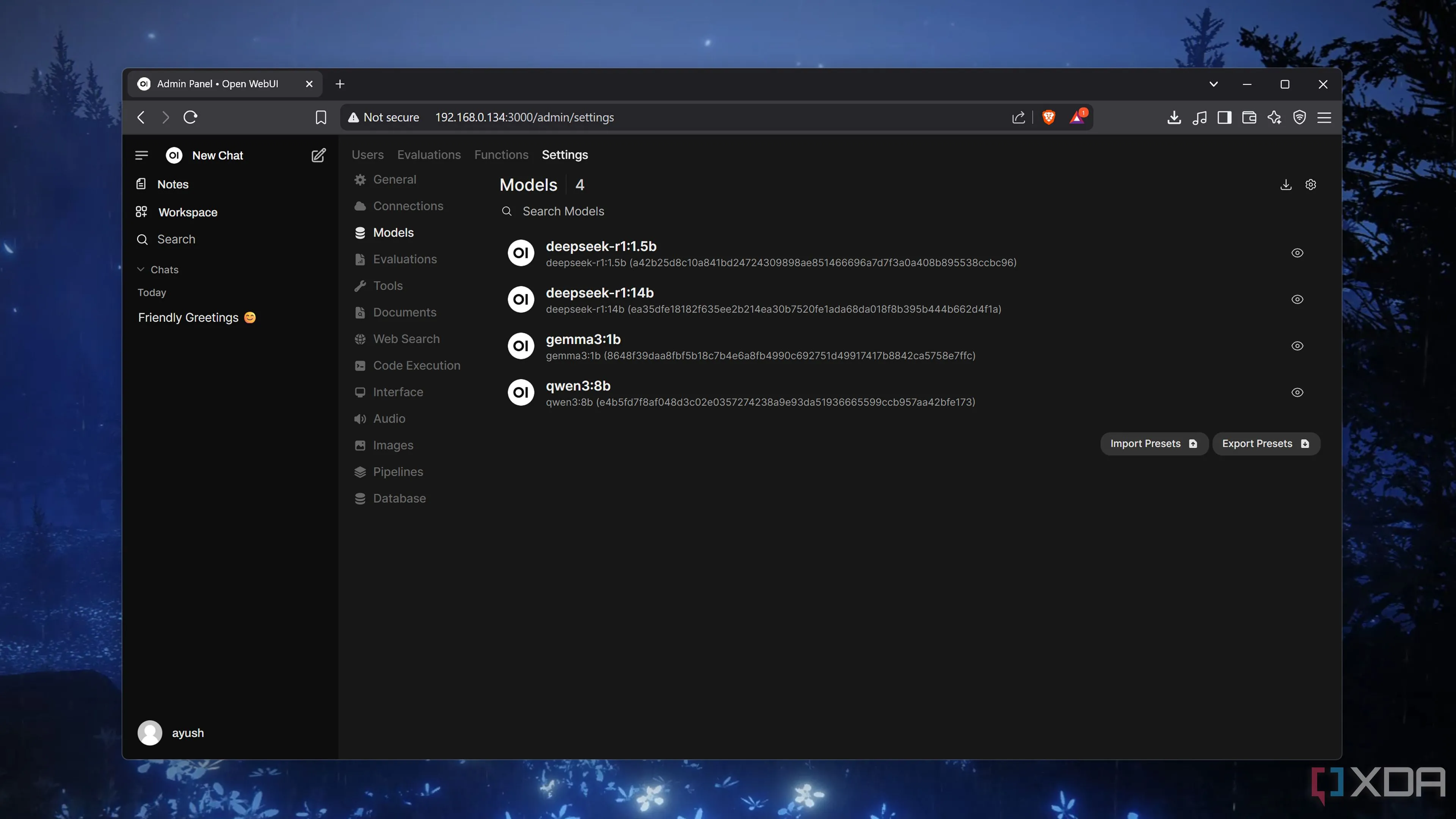

Để có giao diện người dùng thân thiện, tôi đã kết hợp Ollama với Open WebUI. Đây là một giao diện web mã nguồn mở kết nối trực tiếp với API của Ollama, cung cấp một giao diện trò chuyện rõ ràng để tương tác với các mô hình của bạn. Tôi đã triển khai hệ thống này bằng Ngrok để có thể truy cập từ xa một cách an toàn, trong khi Open WebUI cũng xử lý xác thực cơ bản để giữ mọi thứ được bảo mật.

Giao diện truy cập các mô hình LLM trong Ollama

Giao diện truy cập các mô hình LLM trong Ollama

Logo của Ollama

Logo của Ollama

Ollama

Ollama là một nền tảng cho phép tải xuống và chạy nhiều mô hình ngôn ngữ lớn (LLM) mã nguồn mở khác nhau trên máy tính cá nhân của bạn.

Trải Nghiệm Chạy LLM Trên Phần Cứng Cá Nhân: Hiệu Suất Vượt Mong Đợi

AI Cục Bộ Hoạt Động Mượt Mà Hơn Tôi Nghĩ

Bước đầu tiên là chọn một mô hình phù hợp, và tôi đã chọn mô hình DeepSeek R1 với 7 tỷ tham số (7B parameter). Tôi đang chạy mọi thứ trên một chiếc MacBook Air với chip M1 và 16GB bộ nhớ hợp nhất. Rõ ràng đây không phải là một cỗ máy được xây dựng cho các tác vụ AI nặng, nhưng tôi đã ngạc nhiên về khả năng xử lý của nó.

Miễn là tôi chỉ cho LLM chạy một mình, nó hoạt động hoàn toàn ổn định. Chỉ khi tôi cố gắng thực hiện các tác vụ khác trên máy Mac trong khi mô hình đang chạy, nó mới bắt đầu chậm lại.

Thành thật mà nói, tôi đã nghĩ rằng toàn bộ quá trình sẽ là một thảm họa. Chạy LLM là một trong những tác vụ đòi hỏi nhiều nhất đối với phần cứng tiêu dùng. Nhưng vì tôi chỉ sử dụng một mô hình 7B, nó vẫn có thể quản lý được ngay cả trên chiếc MacBook của tôi.

Nói một cách đơn giản, “7B” có nghĩa là mô hình có khoảng bảy tỷ tham số. Bạn có thể coi các tham số như những cài đặt hoặc hướng dẫn nhỏ bên trong mô hình giúp nó hiểu ngôn ngữ, tạo phản hồi hoặc giải quyết vấn đề. Mô hình càng có nhiều tham số, khả năng của nó càng tiên tiến, nhưng điều đó cũng có nghĩa là bạn cần phần cứng mạnh hơn để chạy nó. Bảy tỷ nghe có vẻ rất nhiều, nhưng nó được coi là một trong những mô hình nhẹ hơn, hiệu quả hơn mà vẫn hoạt động tốt cho các tác vụ hữu ích.

Ngay cả với những giới hạn đó, mô hình vẫn xử lý các yêu cầu đơn giản mà không gặp vấn đề gì. Tôi đã sử dụng nó để gỡ lỗi các đoạn code cơ bản trong các chuyến bay và cho các tác vụ ngoại tuyến nhanh chóng. Nếu bạn có phần cứng mạnh hơn, bạn có thể vượt qua giới hạn 7B và chạy các mô hình lớn hơn như 32B hoặc thậm chí 70B tham số, có thể xử lý các câu lệnh phức tạp hơn với khả năng suy luận và độ chính xác tốt hơn.

Tuy nhiên, ngay cả với một thiết lập khiêm tốn, việc chạy LLM cục bộ hóa ra lại thực sự khả thi một cách đáng ngạc nhiên. Nếu bạn muốn tận dụng hơn nữa, bạn có thể thử biến chiếc PC cũ của mình thành một cỗ máy xử lý AI toàn diện cho các tác vụ khác.

Tuyệt Vời, Nhưng Chưa Thay Thế Hoàn Toàn ChatGPT

Vẫn Có Lúc Cần Đến Sức Mạnh Đám Mây

Mặc dù tôi rất thích thú khi chạy một mô hình LLM cục bộ, nhưng nó vẫn chưa hoàn toàn thay thế các công cụ như ChatGPT đối với tôi. Tôi chủ yếu sử dụng thiết lập cục bộ của mình cho các tác vụ nhẹ hơn hoặc khi tôi không có kết nối internet, ví dụ như khi đi du lịch. Đối với các bản sửa lỗi code nhanh, bản nháp hoặc các câu lệnh đơn giản, mô hình 7B hoạt động khá tốt, và thành thật mà nói, nó là quá đủ cho hầu hết các tác vụ liên quan đến LLM của tôi. Tuy nhiên, vẫn có những tình huống mà tôi yêu cầu hiệu suất, độ chính xác hoặc kiến thức chuyên sâu mà các mô hình đám mây cung cấp, và đó là lúc tôi quay lại sử dụng ChatGPT hoặc các công cụ tương tự.

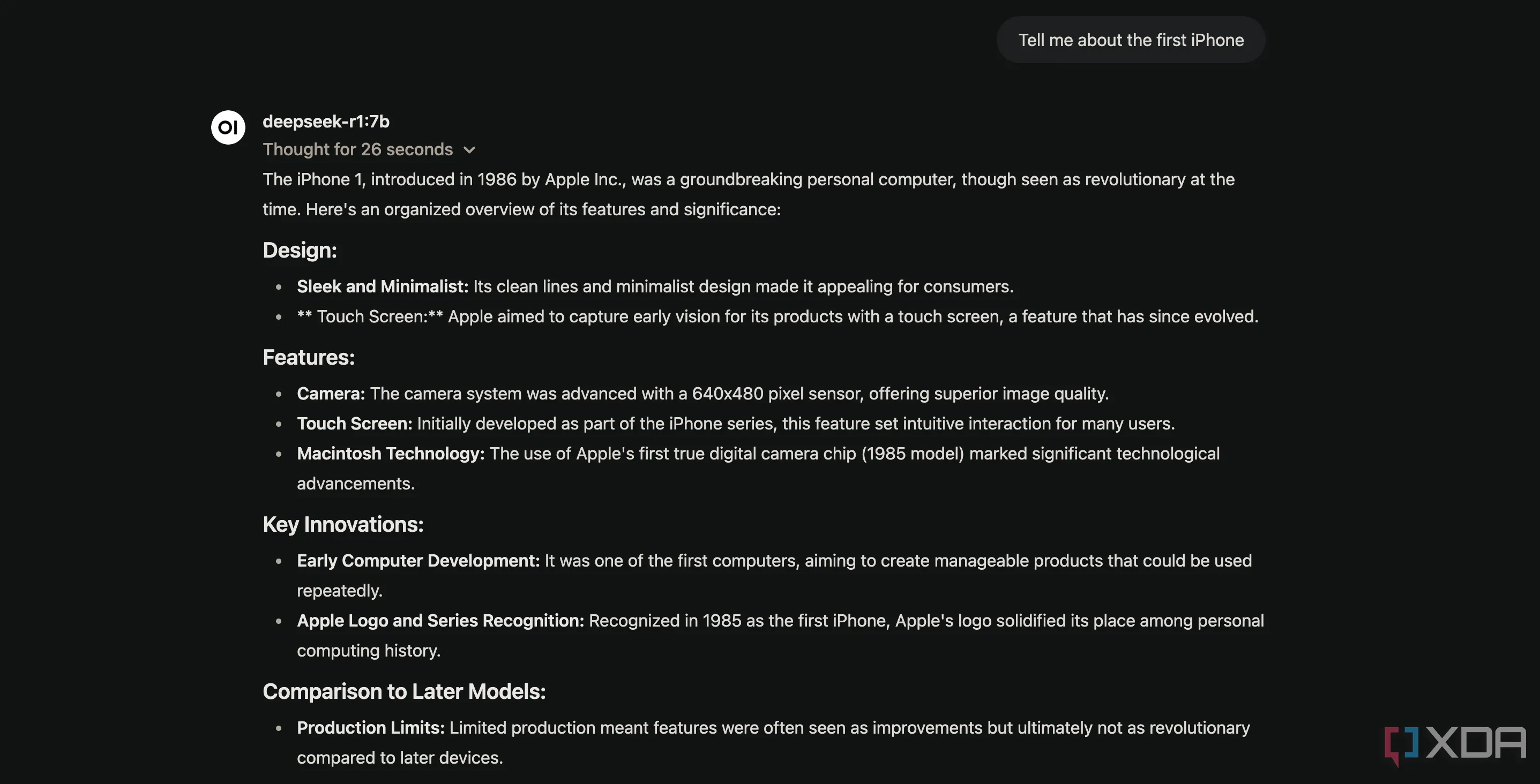

Ví dụ, tôi đã hỏi DeepSeek R1 về chiếc iPhone đầu tiên, và nó đã đưa ra một câu trả lời sai hài hước. Nó tuyên bố iPhone gốc ra mắt vào năm 1986, điều này rõ ràng là không chính xác, và tôi đã cười rất nhiều khi thử những câu hỏi tương tự như vậy.

DeepSeek-R1 chạy cục bộ trên MacBook trả lời sai thông tin về iPhone đầu tiên

DeepSeek-R1 chạy cục bộ trên MacBook trả lời sai thông tin về iPhone đầu tiên

Nếu bạn đang nghĩ đến việc chạy một mô hình LLM trên Raspberry Pi hoặc các phần cứng có công suất thấp khác, bạn sẽ phải điều chỉnh kỳ vọng của mình xuống thấp hơn nữa. Trong những trường hợp đó, bạn có thể sẽ bị giới hạn ở các mô hình nhỏ hơn nhiều, khoảng 1.5 tỷ tham số, chỉ có thể xử lý các truy vấn rất cơ bản.

Các mô hình đám mây như ChatGPT vẫn có lợi thế về khả năng xử lý thô. Chúng thường hỗ trợ các tính năng như tìm kiếm web và plugin, và dữ liệu kiến thức của chúng thường được cập nhật gần đây hơn. Trừ khi bạn có phần cứng cực mạnh để chạy các mô hình lớn hơn nhiều tại chỗ, việc đạt được trải nghiệm tương tự vẫn chưa thực tế vào thời điểm hiện tại.

Kết Luận

Trải nghiệm tự host một mô hình ngôn ngữ lớn (LLM) tại nhà đã chứng minh rằng nó hoàn toàn khả thi và mang lại nhiều lợi ích bất ngờ, đặc biệt là về quyền riêng tư và khả năng kiểm soát dữ liệu. Với sự hỗ trợ của các công cụ như Ollama và Open WebUI, quá trình thiết lập trở nên đơn giản ngay cả với phần cứng khiêm tốn như MacBook Air M1. LLM cục bộ là một giải pháp tuyệt vời cho các tác vụ nhẹ, nhu cầu ngoại tuyến và thử nghiệm cá nhân.

Tuy nhiên, điều quan trọng là phải hiểu rõ giới hạn của chúng. Mặc dù hiệu suất đã vượt quá mong đợi, các mô hình cục bộ vẫn chưa thể thay thế hoàn toàn sức mạnh, độ chính xác và khả năng cập nhật của các LLM nền tảng đám mây như ChatGPT, đặc biệt là với các yêu cầu phức tạp hoặc cần dữ liệu mới nhất. Hãy xem xét nhu cầu sử dụng của bạn để tận dụng tối đa cả hai giải pháp. Bạn đã thử tự host LLM chưa? Hãy chia sẻ trải nghiệm của mình ở phần bình luận dưới đây!